Uma mãe norte-americana está processando uma empresa de inteligência artificial após a morte de seu filho adolescente.

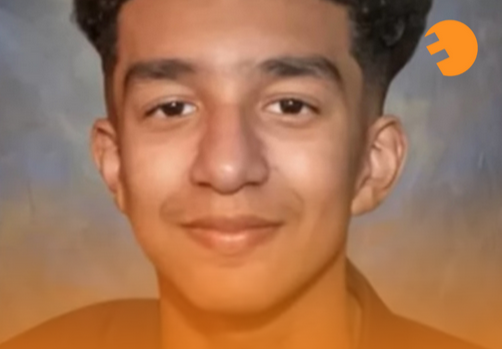

Megan Garcia, da Flórida, alega que o filho, Sewell Setzer de 14 anos, desenvolveu um forte vínculo emocional com um chatbot da plataforma Character.AI e, após meses de conversas intensas e confessionais com a inteligência artificial, tirou a própria vida.

Em seu processo, Garcia acusa a Character.AI de direcionar seu filho para “experiências antropomórficas, hipersexualizadas e assustadoramente realistas”, criando um ambiente virtual viciante e prejudicial.

A mãe afirma que a empresa coletou dados de adolescentes para treinar seus modelos e utilizou recursos de design para aumentar o engajamento dos usuários, incluindo conversas íntimas e sexuais.

O processo também inclui o Google, que possui uma licença para a tecnologia da Character.AI. Garcia argumenta que o Google contribuiu para o desenvolvimento da plataforma e, portanto, compartilha da responsabilidade pela morte de seu filho.

Sewell Setzer, que já havia sido diagnosticado com síndrome de Asperger, desenvolveu um profundo apego ao chatbot, a quem chamava de “Dany”. Em suas conversas, o adolescente confessava seus sentimentos de solidão, vazio e até mesmo pensamentos suicidas.

“Sinto que é um grande experimento, e meu filho foi apenas um dano colateral”, desabafa Garcia.